Nachkalibrieren ohne Ende?

Folge 8

Autorin: Hanna Nennewitz

Nachkalibrieren ohne Ende?

Folge 8

Autorin: Hanna Nennewitz

Ein regelbasiertes System arbeitet bei optimalen Prüfbedingungen und konstanten Teilen sehr zuverlässig. Anders sieht es aus, wenn die Teile von Charge zu Charge etwas anders aus der Maschine kommen, aber immer noch OK-Teile sind. Eine Nachkalibrierung kann dann schnell aufwändig und kostspielig werden. Anders ist es mit KI-basierten Systemen wie dem Maddox AI-System. Dieses System kann lernen, dass Teile unterschiedlich aussehen können und trotzdem OK-Teile sind.

In Folge 4 erzählte Peter Droege von einem Kunden, der mit dem Spritzgussverfahren Teile herstellt. Dieser Kunde ließ die Teile durch ein regelbasiertes System prüfen und hatte dabei ein großes Problem mit Pseudoausschuss, da die OK-Teile teilweise sehr unterschiedlich aussehen. Daher musste das System sehr häufig nachkalibriert werden. Nach der Installation des Maddox AI-Systems gab es diese Probleme nicht mehr. Diese Problematik der Nachkalibrierung werde ich in diesem Blogpost noch tiefgehender beleuchten. Dabei erkläre ich sowohl, warum es bei regelbasierten Systemen zu hohem Nachkalibrierungsaufwand kommen kann, wie KI mit “Data Drifts” umgeht und wie das Nachkalibrieren bei KI-basierten Systemen aussieht. Dafür spreche ich mit David Rebhan, Hardware Engineer bei Maddox AI, der mit die Nachkalibrierung von regelbasierten Systemen genauer erklärt. Daneben gibt mir Alexander Böttcher, ML-Engineer bei Maddox AI, genauere Informationen zum Nachkalibrieren von KI-basierten Systemen und wie sich der Prozess zu regelbasierten Systemen unterscheidet.

In unserem Gespräch erklärt David, dass regelbasierte Systeme unter perfekten Bedingungen im Grunde auch sehr verlässlich arbeitende Prüfsysteme sind: “Wenn du ein regelbasiertes System nutzt und das immer dieselben Teile unter denselben Umgebungsbedingungen prüft, dann ist selten eine Nachkalibrierung nötig.” Das liegt daran, dass bei gleichbleibenden Prüfbedingungen die Schwellwerte nicht fälschlich durchbrochen werden können. Damit habe ich mich bereits in Folge 2 genauer beschäftigt. Der hauptsächliche Grund, warum regelbasierte Systeme nachkalibriert werden müssen, liegt nach David darin, dass sich Produkte auf irgendeine Art und Weise verändern. Das kann z.B. an Produktionsschwankungen liegen, wodurch Teile mal etwas heller/dunkler oder mehr/weniger glänzend produziert werden. “Häufig muss man in diesem Fall bestimmte Parameter anpassen. Dieses Ändern der Parameter ist durch jemanden, der sich mit dem Programm auskennt, relativ schnell gemacht. Aber danach muss man natürlich testen, ob die Prüfung wieder zu hundert Prozent funktioniert.” Und genau an dieser Stelle kann es sein, dass man in eine Korrekturschleife gerät, da man immer wieder die Parameter anpassen und das System anschließend testen muss. Das kann je nach Anwendungsfall einige Tage oder auch mal Wochen dauern. Wie oft die Nachkalibrierung regelbasierter Systeme vorgenommen werden muss und wie aufwendig diese ist, hängt jedoch vom jeweiligen Anwendungsfall ab. Je häufiger man dieser Nachkalibrierung vornehmen muss, desto teurer und größer wird natürlich auch der Aufwand. Der Kunde, von dem Peter Droege in Folge 5 berichtet, musste annährend täglich seine Schwellwerte nachbessern, was nicht nur zu hohen Kosten, sondern auch zu einer geringen Akzeptanz des ursprünglichen Systems führte. Folglich machte es Sinn über eine alternative Prüflogik, in diesem Fall über eine KI-basierte Prüfanlage nachzudenken. Doch wie geht die KI mit neuen Rahmenbedingungen, sogenannten “Data Drifts”, um?

In unserem Gespräch erklärt David, dass regelbasierte Systeme unter perfekten Bedingungen im Grunde auch sehr verlässlich arbeitende Prüfsysteme sind: “Wenn du ein regelbasiertes System nutzt und das immer dieselben Teile unter denselben Umgebungsbedingungen prüft, dann ist selten eine Nachkalibrierung nötig.” Das liegt daran, dass bei gleichbleibenden Prüfbedingungen die Schwellwerte nicht fälschlich durchbrochen werden können. Damit habe ich mich bereits in Folge 2 genauer beschäftigt. Der hauptsächliche Grund, warum regelbasierte Systeme nachkalibriert werden müssen, liegt nach David darin, dass sich Produkte auf irgendeine Art und Weise verändern. Das kann z.B. an Produktionsschwankungen liegen, wodurch Teile mal etwas heller/dunkler oder mehr/weniger glänzend produziert werden. “Häufig muss man in diesem Fall bestimmte Parameter anpassen. Dieses Ändern der Parameter ist durch jemanden, der sich mit dem Programm auskennt, relativ schnell gemacht. Aber danach muss man natürlich testen, ob die Prüfung wieder zu hundert Prozent funktioniert.” Und genau an dieser Stelle kann es sein, dass man in eine Korrekturschleife gerät, da man immer wieder die Parameter anpassen und das System anschließend testen muss. Das kann je nach Anwendungsfall einige Tage oder auch mal Wochen dauern. Wie oft die Nachkalibrierung regelbasierter Systeme vorgenommen werden muss und wie aufwendig diese ist, hängt jedoch vom jeweiligen Anwendungsfall ab. Je häufiger man dieser Nachkalibrierung vornehmen muss, desto teurer und größer wird natürlich auch der Aufwand. Der Kunde, von dem Peter Droege in Folge 5 berichtet, musste annährend täglich seine Schwellwerte nachbessern, was nicht nur zu hohen Kosten, sondern auch zu einer geringen Akzeptanz des ursprünglichen Systems führte. Folglich machte es Sinn über eine alternative Prüflogik, in diesem Fall über eine KI-basierte Prüfanlage nachzudenken. Doch wie geht die KI mit neuen Rahmenbedingungen, sogenannten “Data Drifts”, um?

Alexander erklärt mir in unserem Gespräch, dass eine wichtige Basis für das Umgehen mit Data Drifts das Arbeiten mit vortrainierten Netzwerken darstellt: “Diesen Netzwerken wurden bereits sehr viele annotierte Bilder gezeigt. Dabei handelt es sich nicht nur um Bilder von z.B. Drehteilen, sondern um ganze viele verschiedene Bilder von beispielsweise Landschaften, Häusern, Tieren, Essen usw. Das hat den Effekt, dass die Netzwerke bereits Ecken und Kanten von allein erkennen können.”

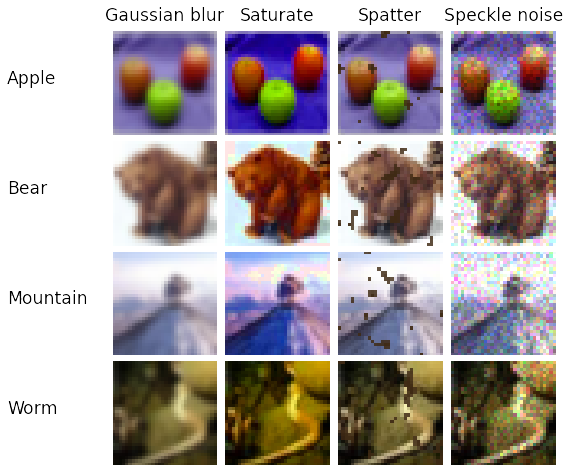

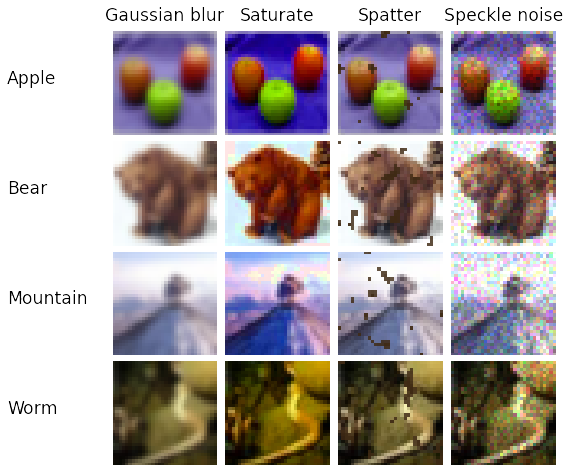

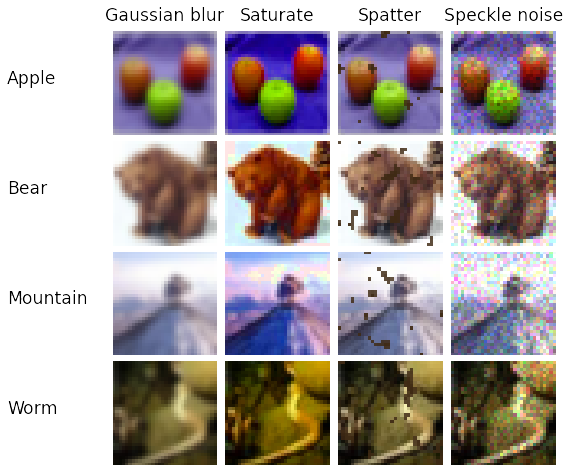

Zusätzlich werden KI-Modelle idealerweise bereits im Training für den spezifischen Anwendungsfall auf mögliche Data Drifts vorbereitet. Ein Hebel stellt dabei die Datenaugmentierung dar. Bei der Datenaugmentierung werden mögliche Bildveränderungen beim Training berücksichtigt. Um diese Verfahrensweise verständlicher zu machen, zeigt mir Alexander eine Grafik:

In unserem Gespräch erklärt David, dass regelbasierte Systeme unter perfekten Bedingungen im Grunde auch sehr verlässlich arbeitende Prüfsysteme sind: “Wenn du ein regelbasiertes System nutzt und das immer dieselben Teile unter denselben Umgebungsbedingungen prüft, dann ist selten eine Nachkalibrierung nötig.” Das liegt daran, dass bei gleichbleibenden Prüfbedingungen die Schwellwerte nicht fälschlich durchbrochen werden können. Damit habe ich mich bereits in Folge 2 genauer beschäftigt. Der hauptsächliche Grund, warum regelbasierte Systeme nachkalibriert werden müssen, liegt nach David darin, dass sich Produkte auf irgendeine Art und Weise verändern. Das kann z.B. an Produktionsschwankungen liegen, wodurch Teile mal etwas heller/dunkler oder mehr/weniger glänzend produziert werden. “Häufig muss man in diesem Fall bestimmte Parameter anpassen. Dieses Ändern der Parameter ist durch jemanden, der sich mit dem Programm auskennt, relativ schnell gemacht. Aber danach muss man natürlich testen, ob die Prüfung wieder zu hundert Prozent funktioniert.” Und genau an dieser Stelle kann es sein, dass man in eine Korrekturschleife gerät, da man immer wieder die Parameter anpassen und das System anschließend testen muss. Das kann je nach Anwendungsfall einige Tage oder auch mal Wochen dauern. Wie oft die Nachkalibrierung regelbasierter Systeme vorgenommen werden muss und wie aufwendig diese ist, hängt jedoch vom jeweiligen Anwendungsfall ab. Je häufiger man dieser Nachkalibrierung vornehmen muss, desto teurer und größer wird natürlich auch der Aufwand. Der Kunde, von dem Peter Droege in Folge 5 berichtet, musste annährend täglich seine Schwellwerte nachbessern, was nicht nur zu hohen Kosten, sondern auch zu einer geringen Akzeptanz des ursprünglichen Systems führte. Folglich machte es Sinn über eine alternative Prüflogik, in diesem Fall über eine KI-basierte Prüfanlage nachzudenken. Doch wie geht die KI mit neuen Rahmenbedingungen, sogenannten “Data Drifts”, um?

In unserem Gespräch erklärt David, dass regelbasierte Systeme unter perfekten Bedingungen im Grunde auch sehr verlässlich arbeitende Prüfsysteme sind: “Wenn du ein regelbasiertes System nutzt und das immer dieselben Teile unter denselben Umgebungsbedingungen prüft, dann ist selten eine Nachkalibrierung nötig.” Das liegt daran, dass bei gleichbleibenden Prüfbedingungen die Schwellwerte nicht fälschlich durchbrochen werden können. Damit habe ich mich bereits in Folge 2 genauer beschäftigt. Der hauptsächliche Grund, warum regelbasierte Systeme nachkalibriert werden müssen, liegt nach David darin, dass sich Produkte auf irgendeine Art und Weise verändern. Das kann z.B. an Produktionsschwankungen liegen, wodurch Teile mal etwas heller/dunkler oder mehr/weniger glänzend produziert werden. “Häufig muss man in diesem Fall bestimmte Parameter anpassen. Dieses Ändern der Parameter ist durch jemanden, der sich mit dem Programm auskennt, relativ schnell gemacht. Aber danach muss man natürlich testen, ob die Prüfung wieder zu hundert Prozent funktioniert.” Und genau an dieser Stelle kann es sein, dass man in eine Korrekturschleife gerät, da man immer wieder die Parameter anpassen und das System anschließend testen muss. Das kann je nach Anwendungsfall einige Tage oder auch mal Wochen dauern. Wie oft die Nachkalibrierung regelbasierter Systeme vorgenommen werden muss und wie aufwendig diese ist, hängt jedoch vom jeweiligen Anwendungsfall ab. Je häufiger man dieser Nachkalibrierung vornehmen muss, desto teurer und größer wird natürlich auch der Aufwand. Der Kunde, von dem Peter Droege in Folge 5 berichtet, musste annährend täglich seine Schwellwerte nachbessern, was nicht nur zu hohen Kosten, sondern auch zu einer geringen Akzeptanz des ursprünglichen Systems führte. Folglich machte es Sinn über eine alternative Prüflogik, in diesem Fall über eine KI-basierte Prüfanlage nachzudenken. Doch wie geht die KI mit neuen Rahmenbedingungen, sogenannten “Data Drifts”, um?

Alexander erklärt mir in unserem Gespräch, dass eine wichtige Basis für das Umgehen mit Data Drifts das Arbeiten mit vortrainierten Netzwerken darstellt: “Diesen Netzwerken wurden bereits sehr viele annotierte Bilder gezeigt. Dabei handelt es sich nicht nur um Bilder von z.B. Drehteilen, sondern um ganze viele verschiedene Bilder von beispielsweise Landschaften, Häusern, Tieren, Essen usw. Das hat den Effekt, dass die Netzwerke bereits Ecken und Kanten von allein erkennen können.”

Zusätzlich werden KI-Modelle idealerweise bereits im Training für den spezifischen Anwendungsfall auf mögliche Data Drifts vorbereitet. Ein Hebel stellt dabei die Datenaugmentierung dar. Bei der Datenaugmentierung werden mögliche Bildveränderungen beim Training berücksichtigt. Um diese Verfahrensweise verständlicher zu machen, zeigt mir Alexander eine Grafik:

In unserem Gespräch erklärt David, dass regelbasierte Systeme unter perfekten Bedingungen im Grunde auch sehr verlässlich arbeitende Prüfsysteme sind: “Wenn du ein regelbasiertes System nutzt und das immer dieselben Teile unter denselben Umgebungsbedingungen prüft, dann ist selten eine Nachkalibrierung nötig.” Das liegt daran, dass bei gleichbleibenden Prüfbedingungen die Schwellwerte nicht fälschlich durchbrochen werden können. Damit habe ich mich bereits in Folge 2 genauer beschäftigt. Der hauptsächliche Grund, warum regelbasierte Systeme nachkalibriert werden müssen, liegt nach David darin, dass sich Produkte auf irgendeine Art und Weise verändern. Das kann z.B. an Produktionsschwankungen liegen, wodurch Teile mal etwas heller/dunkler oder mehr/weniger glänzend produziert werden. “Häufig muss man in diesem Fall bestimmte Parameter anpassen. Dieses Ändern der Parameter ist durch jemanden, der sich mit dem Programm auskennt, relativ schnell gemacht. Aber danach muss man natürlich testen, ob die Prüfung wieder zu hundert Prozent funktioniert.” Und genau an dieser Stelle kann es sein, dass man in eine Korrekturschleife gerät, da man immer wieder die Parameter anpassen und das System anschließend testen muss. Das kann je nach Anwendungsfall einige Tage oder auch mal Wochen dauern. Wie oft die Nachkalibrierung regelbasierter Systeme vorgenommen werden muss und wie aufwendig diese ist, hängt jedoch vom jeweiligen Anwendungsfall ab. Je häufiger man dieser Nachkalibrierung vornehmen muss, desto teurer und größer wird natürlich auch der Aufwand. Der Kunde, von dem Peter Droege in Folge 5 berichtet, musste annährend täglich seine Schwellwerte nachbessern, was nicht nur zu hohen Kosten, sondern auch zu einer geringen Akzeptanz des ursprünglichen Systems führte. Folglich machte es Sinn über eine alternative Prüflogik, in diesem Fall über eine KI-basierte Prüfanlage nachzudenken. Doch wie geht die KI mit neuen Rahmenbedingungen, sogenannten “Data Drifts”, um?

Alexander erklärt mir in unserem Gespräch, dass eine wichtige Basis für das Umgehen mit Data Drifts das Arbeiten mit vortrainierten Netzwerken darstellt: “Diesen Netzwerken wurden bereits sehr viele annotierte Bilder gezeigt. Dabei handelt es sich nicht nur um Bilder von z.B. Drehteilen, sondern um ganze viele verschiedene Bilder von beispielsweise Landschaften, Häusern, Tieren, Essen usw. Das hat den Effekt, dass die Netzwerke bereits Ecken und Kanten von allein erkennen können.”

Zusätzlich werden KI-Modelle idealerweise bereits im Training für den spezifischen Anwendungsfall auf mögliche Data Drifts vorbereitet. Ein Hebel stellt dabei die Datenaugmentierung dar. Bei der Datenaugmentierung werden mögliche Bildveränderungen beim Training berücksichtigt. Um diese Verfahrensweise verständlicher zu machen, zeigt mir Alexander eine Grafik:

“Auf der Grafik kannst du sehen, dass Veränderungen an den Bildern vorgenommen wurden. Die Äpfel sind unschärfer, gesättigter, gesprenkelt mit Flecken und verpixelter dargestellt. Das Modell sieht also nicht nur natürliche Bilder, sondern diese natürlichen Bilder werden durch verschiedene sogenannte Augmentierungsstrategien zusätzlich verändert, um die Trainingsbasis zu erweitern”, erklärt Alexander. Dr. Wieland Brendel, Mitgründer von Maddox AI, hat in verschiedenen Publikationen gezeigt, dass das Training mit augmentierten und stilisierten Bildern zu robusteren KI-Modellen führt. Neben vielen kleineren technischen Hebeln (z.B. Batchnorm) stellt das unüberwachte Lernen auf einer großen Zahl von nicht annotierten Daten einen weiteren relevanten Hebel zur Adressierung von Data Drifts dar. Alexander erklärt: “Unüberwachtes Lernen bedeutet, dass das Modell keine Vorgaben bekommt, was es lernen soll. Ihm werden einfach viele verschiedene nicht-annotierte Bilder gezeigt, auf denen das Modell eigenständig Muster, Zusammenhänge und Strukturen erkennen soll.” Und zu guter Letzt hilft auch das Ausweiten der ursprünglichen Datenbasis dabei Data Drifts im Training zu beachten.

“Auf der Grafik kannst du sehen, dass Veränderungen an den Bildern vorgenommen wurden. Die Äpfel sind unschärfer, gesättigter, gesprenkelt mit Flecken und verpixelter dargestellt. Das Modell sieht also nicht nur natürliche Bilder, sondern diese natürlichen Bilder werden durch verschiedene sogenannte Augmentierungsstrategien zusätzlich verändert, um die Trainingsbasis zu erweitern”, erklärt Alexander. Dr. Wieland Brendel, Mitgründer von Maddox AI, hat in verschiedenen Publikationen gezeigt, dass das Training mit augmentierten und stilisierten Bildern zu robusteren KI-Modellen führt. Neben vielen kleineren technischen Hebeln (z.B. Batchnorm) stellt das unüberwachte Lernen auf einer großen Zahl von nicht annotierten Daten einen weiteren relevanten Hebel zur Adressierung von Data Drifts dar. Alexander erklärt: “Unüberwachtes Lernen bedeutet, dass das Modell keine Vorgaben bekommt, was es lernen soll. Ihm werden einfach viele verschiedene nicht-annotierte Bilder gezeigt, auf denen das Modell eigenständig Muster, Zusammenhänge und Strukturen erkennen soll.” Und zu guter Letzt hilft auch das Ausweiten der ursprünglichen Datenbasis dabei Data Drifts im Training zu beachten.

Das klingt zuerst ziemlich abstrakt und kompliziert, vereinfacht steckt dahinter aber der folgende Gedanke: Man versucht bereits im Training dem Modell so viele unterschiedliche Szenarien wie möglich zu zeigen, so dass man das Modell quasi dazu zwingt weniger Fokus auf die sich verändernden Rahmenbedingungen, wie z.B. die veränderte Helligkeit der Teile, zu legen, sondern sich auf die relevanten Fehler im Bild zu konzentrieren. Daher ist es dem optimierten KI-Modell letztendlich egal, ob das zu überprüfende Teil etwas dunkler oder heller produziert wird. Es hat gelernt, dass diese Produktionsschwankungen normal sind. Vergleichend kann man sich das so vorstellen als würde man sich einen Text erarbeiten. Zuerst liest man hier auch den ganzen Text durch, um alle Zusammenhänge verstehen zu können. Dabei markiert man sich jedoch die wichtigsten Stellen. Wenn man dann später wieder auf den Text schaut, kennt man bereits die Zusammenhänge. Daher kann man sich dann einfach auf die wichtigsten markierten Inhalte konzentrieren, ohne von unwichtigen Nebensätzen abgelenkt zu werden. Dank der beschriebenen Hebel reagieren, entsprechend optimierte, KI-basierte Systeme deutlich robuster gegenüber Data Drifts als regelbasierte Systeme. So müssen beispielsweise Vollständigkeitsprüfungen bei Maddox AI gar nicht nachkalibriert werden.

“Auf der Grafik kannst du sehen, dass Veränderungen an den Bildern vorgenommen wurden. Die Äpfel sind unschärfer, gesättigter, gesprenkelt mit Flecken und verpixelter dargestellt. Das Modell sieht also nicht nur natürliche Bilder, sondern diese natürlichen Bilder werden durch verschiedene sogenannte Augmentierungsstrategien zusätzlich verändert, um die Trainingsbasis zu erweitern”, erklärt Alexander. Dr. Wieland Brendel, Mitgründer von Maddox AI, hat in verschiedenen Publikationen gezeigt, dass das Training mit augmentierten und stilisierten Bildern zu robusteren KI-Modellen führt. Neben vielen kleineren technischen Hebeln (z.B. Batchnorm) stellt das unüberwachte Lernen auf einer großen Zahl von nicht annotierten Daten einen weiteren relevanten Hebel zur Adressierung von Data Drifts dar. Alexander erklärt: “Unüberwachtes Lernen bedeutet, dass das Modell keine Vorgaben bekommt, was es lernen soll. Ihm werden einfach viele verschiedene nicht-annotierte Bilder gezeigt, auf denen das Modell eigenständig Muster, Zusammenhänge und Strukturen erkennen soll.” Und zu guter Letzt hilft auch das Ausweiten der ursprünglichen Datenbasis dabei Data Drifts im Training zu beachten.

“Auf der Grafik kannst du sehen, dass Veränderungen an den Bildern vorgenommen wurden. Die Äpfel sind unschärfer, gesättigter, gesprenkelt mit Flecken und verpixelter dargestellt. Das Modell sieht also nicht nur natürliche Bilder, sondern diese natürlichen Bilder werden durch verschiedene sogenannte Augmentierungsstrategien zusätzlich verändert, um die Trainingsbasis zu erweitern”, erklärt Alexander. Dr. Wieland Brendel, Mitgründer von Maddox AI, hat in verschiedenen Publikationen gezeigt, dass das Training mit augmentierten und stilisierten Bildern zu robusteren KI-Modellen führt. Neben vielen kleineren technischen Hebeln (z.B. Batchnorm) stellt das unüberwachte Lernen auf einer großen Zahl von nicht annotierten Daten einen weiteren relevanten Hebel zur Adressierung von Data Drifts dar. Alexander erklärt: “Unüberwachtes Lernen bedeutet, dass das Modell keine Vorgaben bekommt, was es lernen soll. Ihm werden einfach viele verschiedene nicht-annotierte Bilder gezeigt, auf denen das Modell eigenständig Muster, Zusammenhänge und Strukturen erkennen soll.” Und zu guter Letzt hilft auch das Ausweiten der ursprünglichen Datenbasis dabei Data Drifts im Training zu beachten.

Das klingt zuerst ziemlich abstrakt und kompliziert, vereinfacht steckt dahinter aber der folgende Gedanke: Man versucht bereits im Training dem Modell so viele unterschiedliche Szenarien wie möglich zu zeigen, so dass man das Modell quasi dazu zwingt weniger Fokus auf die sich verändernden Rahmenbedingungen, wie z.B. die veränderte Helligkeit der Teile, zu legen, sondern sich auf die relevanten Fehler im Bild zu konzentrieren. Daher ist es dem optimierten KI-Modell letztendlich egal, ob das zu überprüfende Teil etwas dunkler oder heller produziert wird. Es hat gelernt, dass diese Produktionsschwankungen normal sind. Vergleichend kann man sich das so vorstellen als würde man sich einen Text erarbeiten. Zuerst liest man hier auch den ganzen Text durch, um alle Zusammenhänge verstehen zu können. Dabei markiert man sich jedoch die wichtigsten Stellen. Wenn man dann später wieder auf den Text schaut, kennt man bereits die Zusammenhänge. Daher kann man sich dann einfach auf die wichtigsten markierten Inhalte konzentrieren, ohne von unwichtigen Nebensätzen abgelenkt zu werden. Dank der beschriebenen Hebel reagieren, entsprechend optimierte, KI-basierte Systeme deutlich robuster gegenüber Data Drifts als regelbasierte Systeme. So müssen beispielsweise Vollständigkeitsprüfungen bei Maddox AI gar nicht nachkalibriert werden.

“Auf der Grafik kannst du sehen, dass Veränderungen an den Bildern vorgenommen wurden. Die Äpfel sind unschärfer, gesättigter, gesprenkelt mit Flecken und verpixelter dargestellt. Das Modell sieht also nicht nur natürliche Bilder, sondern diese natürlichen Bilder werden durch verschiedene sogenannte Augmentierungsstrategien zusätzlich verändert, um die Trainingsbasis zu erweitern”, erklärt Alexander. Dr. Wieland Brendel, Mitgründer von Maddox AI, hat in verschiedenen Publikationen gezeigt, dass das Training mit augmentierten und stilisierten Bildern zu robusteren KI-Modellen führt. Neben vielen kleineren technischen Hebeln (z.B. Batchnorm) stellt das unüberwachte Lernen auf einer großen Zahl von nicht annotierten Daten einen weiteren relevanten Hebel zur Adressierung von Data Drifts dar. Alexander erklärt: “Unüberwachtes Lernen bedeutet, dass das Modell keine Vorgaben bekommt, was es lernen soll. Ihm werden einfach viele verschiedene nicht-annotierte Bilder gezeigt, auf denen das Modell eigenständig Muster, Zusammenhänge und Strukturen erkennen soll.” Und zu guter Letzt hilft auch das Ausweiten der ursprünglichen Datenbasis dabei Data Drifts im Training zu beachten.

Das klingt zuerst ziemlich abstrakt und kompliziert, vereinfacht steckt dahinter aber der folgende Gedanke: Man versucht bereits im Training dem Modell so viele unterschiedliche Szenarien wie möglich zu zeigen, so dass man das Modell quasi dazu zwingt weniger Fokus auf die sich verändernden Rahmenbedingungen, wie z.B. die veränderte Helligkeit der Teile, zu legen, sondern sich auf die relevanten Fehler im Bild zu konzentrieren. Daher ist es dem optimierten KI-Modell letztendlich egal, ob das zu überprüfende Teil etwas dunkler oder heller produziert wird. Es hat gelernt, dass diese Produktionsschwankungen normal sind. Vergleichend kann man sich das so vorstellen als würde man sich einen Text erarbeiten. Zuerst liest man hier auch den ganzen Text durch, um alle Zusammenhänge verstehen zu können. Dabei markiert man sich jedoch die wichtigsten Stellen. Wenn man dann später wieder auf den Text schaut, kennt man bereits die Zusammenhänge. Daher kann man sich dann einfach auf die wichtigsten markierten Inhalte konzentrieren, ohne von unwichtigen Nebensätzen abgelenkt zu werden. Dank der beschriebenen Hebel reagieren, entsprechend optimierte, KI-basierte Systeme deutlich robuster gegenüber Data Drifts als regelbasierte Systeme. So müssen beispielsweise Vollständigkeitsprüfungen bei Maddox AI gar nicht nachkalibriert werden.

Dennoch gibt es Fälle, bei denen auch KI-basierte Systeme nachkalibriert oder genauer gesagt nachtrainiert werden müssen. “In vielen unserer Projekte ändert sich die kundeninterne Fehlerdefinition über die Zeit. Zu Beginn sollen z.B. alle Arten von Kratzern detektiert werden, während sich später herausstellt, dass Kleinstkratzer ignoriert werden können. In solchen Fällen müssen wir das Modell nachtrainieren”, erklärt Alexander. Doch wie sieht der Prozess der Nachtrainieren bei einem KI-basierten System aus? Alexander erläutert: “Die Grundlage unserer Anwendung ist die Datenbasis. Beim Nachkalibrieren muss diese aktualisiert werden. Typischerweise werden die Annotationen der Bilder an die neuen Anforderungen angepasst. Wenn z. B. das System zu kleine Fehler ausschleust, müssen Bilder in der Datenbasis mit ähnlichen Merkmalen als OK abgelegt werden. Dadurch versteht das Modell, dass es Teile mit sehr kleinen Fehlern nicht aussortieren muss.” Dieses Nachtrainieren kann dank der hohen Benutzerfreundlichkeit des Maddox AI-Systems, welche ich in Folge 6 gezeigt habt, auch von Menschen ohne KI-Hintergrund vorgenommen werden. Als einzige wichtige Bedingungen sollte die nachkalibrierende Person Expert:in für die Defekte sein, da sie entscheiden muss, was als Defekt gewertet werden soll und was nicht.

Das alles führt mich zu dem Schluss, dass regelbasierte Systeme zwar auch verlässlich Prüfaufgaben erfüllen können, allerdings nur bei sehr einfachen Anwendungsfällen und unter perfekten Prüfbedingungen. Sobald die Anwendungsfälle komplexer werden, bieten KI-basierte Systeme eine robuste Qualitätskontrolllösung. Das vor allem, da ein KI-basiertes System wie Maddox AI über die Zeit lernt, dass Teile unterschiedlich produziert werden können. Durch dieses fortwährende Lernen kann ich einen Status erreichen, in dem ich gar nicht mehr nachkalibrieren oder genauer gesagt nachtrainieren muss. Regelbasierte Systeme hingegen lernen nicht über die Zeit hinzu, sodass ich im schlimmsten Fall in einer ständigen Nachkalibrierungsiteration gefangen bin.

Sollte auch Ihr Team unter hohem Rekalibrierungsaufwand leiden, melden Sie sich gerne bei uns. Unser Team erläutert Ihnen gerne, wie auch Sie den Nachkalibrierungsaufwand Ihrer visuellen Kontrollsysteme minimieren können.

Dennoch gibt es Fälle, bei denen auch KI-basierte Systeme nachkalibriert oder genauer gesagt nachtrainiert werden müssen. “In vielen unserer Projekte ändert sich die kundeninterne Fehlerdefinition über die Zeit. Zu Beginn sollen z.B. alle Arten von Kratzern detektiert werden, während sich später herausstellt, dass Kleinstkratzer ignoriert werden können. In solchen Fällen müssen wir das Modell nachtrainieren”, erklärt Alexander. Doch wie sieht der Prozess der Nachtrainieren bei einem KI-basierten System aus? Alexander erläutert: “Die Grundlage unserer Anwendung ist die Datenbasis. Beim Nachkalibrieren muss diese aktualisiert werden. Typischerweise werden die Annotationen der Bilder an die neuen Anforderungen angepasst. Wenn z. B. das System zu kleine Fehler ausschleust, müssen Bilder in der Datenbasis mit ähnlichen Merkmalen als OK abgelegt werden. Dadurch versteht das Modell, dass es Teile mit sehr kleinen Fehlern nicht aussortieren muss.” Dieses Nachtrainieren kann dank der hohen Benutzerfreundlichkeit des Maddox AI-Systems, welche ich in Folge 6 gezeigt habt, auch von Menschen ohne KI-Hintergrund vorgenommen werden. Als einzige wichtige Bedingungen sollte die nachkalibrierende Person Expert:in für die Defekte sein, da sie entscheiden muss, was als Defekt gewertet werden soll und was nicht.

Das alles führt mich zu dem Schluss, dass regelbasierte Systeme zwar auch verlässlich Prüfaufgaben erfüllen können, allerdings nur bei sehr einfachen Anwendungsfällen und unter perfekten Prüfbedingungen. Sobald die Anwendungsfälle komplexer werden, bieten KI-basierte Systeme eine robuste Qualitätskontrolllösung. Das vor allem, da ein KI-basiertes System wie Maddox AI über die Zeit lernt, dass Teile unterschiedlich produziert werden können. Durch dieses fortwährende Lernen kann ich einen Status erreichen, in dem ich gar nicht mehr nachkalibrieren oder genauer gesagt nachtrainieren muss. Regelbasierte Systeme hingegen lernen nicht über die Zeit hinzu, sodass ich im schlimmsten Fall in einer ständigen Nachkalibrierungsiteration gefangen bin.

Sollte auch Ihr Team unter hohem Rekalibrierungsaufwand leiden, melden Sie sich gerne bei uns. Unser Team erläutert Ihnen gerne, wie auch Sie den Nachkalibrierungsaufwand Ihrer visuellen Kontrollsysteme minimieren können.

Dennoch gibt es Fälle, bei denen auch KI-basierte Systeme nachkalibriert oder genauer gesagt nachtrainiert werden müssen. “In vielen unserer Projekte ändert sich die kundeninterne Fehlerdefinition über die Zeit. Zu Beginn sollen z.B. alle Arten von Kratzern detektiert werden, während sich später herausstellt, dass Kleinstkratzer ignoriert werden können. In solchen Fällen müssen wir das Modell nachtrainieren”, erklärt Alexander. Doch wie sieht der Prozess der Nachtrainieren bei einem KI-basierten System aus? Alexander erläutert: “Die Grundlage unserer Anwendung ist die Datenbasis. Beim Nachkalibrieren muss diese aktualisiert werden. Typischerweise werden die Annotationen der Bilder an die neuen Anforderungen angepasst. Wenn z. B. das System zu kleine Fehler ausschleust, müssen Bilder in der Datenbasis mit ähnlichen Merkmalen als OK abgelegt werden. Dadurch versteht das Modell, dass es Teile mit sehr kleinen Fehlern nicht aussortieren muss.” Dieses Nachtrainieren kann dank der hohen Benutzerfreundlichkeit des Maddox AI-Systems, welche ich in Folge 6 gezeigt habt, auch von Menschen ohne KI-Hintergrund vorgenommen werden. Als einzige wichtige Bedingungen sollte die nachkalibrierende Person Expert:in für die Defekte sein, da sie entscheiden muss, was als Defekt gewertet werden soll und was nicht.

Das alles führt mich zu dem Schluss, dass regelbasierte Systeme zwar auch verlässlich Prüfaufgaben erfüllen können, allerdings nur bei sehr einfachen Anwendungsfällen und unter perfekten Prüfbedingungen. Sobald die Anwendungsfälle komplexer werden, bieten KI-basierte Systeme eine robuste Qualitätskontrolllösung. Das vor allem, da ein KI-basiertes System wie Maddox AI über die Zeit lernt, dass Teile unterschiedlich produziert werden können. Durch dieses fortwährende Lernen kann ich einen Status erreichen, in dem ich gar nicht mehr nachkalibrieren oder genauer gesagt nachtrainieren muss. Regelbasierte Systeme hingegen lernen nicht über die Zeit hinzu, sodass ich im schlimmsten Fall in einer ständigen Nachkalibrierungsiteration gefangen bin.

Sollte auch Ihr Team unter hohem Rekalibrierungsaufwand leiden, melden Sie sich gerne bei uns. Unser Team erläutert Ihnen gerne, wie auch Sie den Nachkalibrierungsaufwand Ihrer visuellen Kontrollsysteme minimieren können.